CVPR 2022 FSL

CVPR2022列表已经放出来一段时间了,最近也一直在看感兴趣的论文,先放一个few-shot learning的文章

1、Task Discrepancy Maximization for Fine-grained Few-Shot Classification

先把文章的作者还有机构放在这里。

之前写了很多关于FSL论文介绍的文章,对于fine-grained来说,需要让模型能关注到很多细节的特征,本文设计了一种注意力机制,让模型跟关注和类别相关的细节特征,也就是给更关键的细节特征更高的权重。为了得出这些权重,肯定需要一个评分的东西。

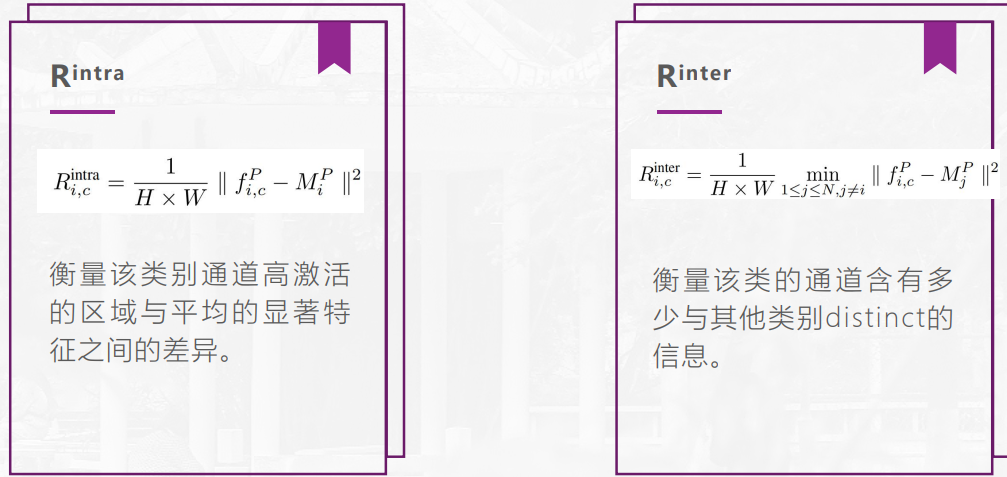

先介绍一下作者引入的两个评分,一个是Rintra即类内评分,另一个是Rinter是类间评分。

(这图是之前讲论文做ppt里面的:) )

介绍一下里面的符号表示,fp代表是个时刻feature的平均,M表示这个类别所有prototype的均值。所以对于Rintra,表示这一个数据多个checkpoints下的平均feature和这个类别所有平均feature的差别,就可以衡量出该数据和平均显著特征之间的差距,当作类内评分。

另外对于Rinter,就好理解很多。就是这个类别的f和其他类别M的差,可以衡量出和其他类别有多少distinct的信息,用来区分不同类别,拉大类间差距。

因此,Rintra越小,Rinter越大,该通道的信息越多,就要给更大的权重。

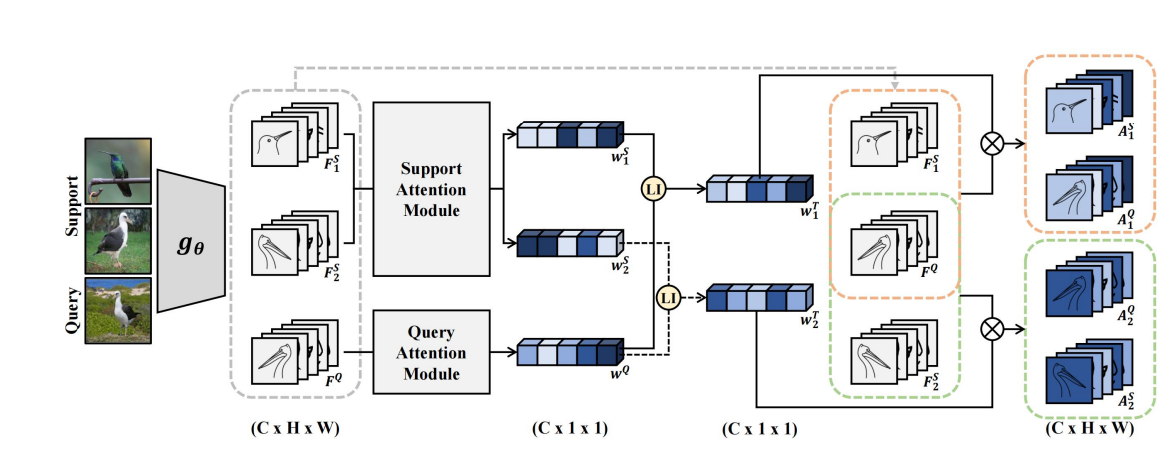

方法流程图如下。

很简单,由两个模块SAM,和QAM提取出权重,然后加到各自的feature上,变成最后可以用的feature。

下面分别介绍一下QAM和SAM

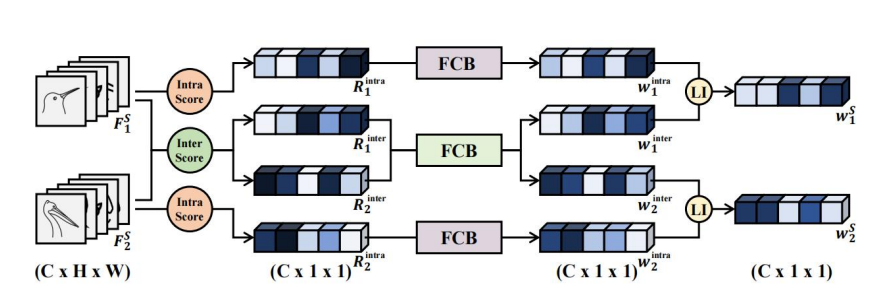

SAM

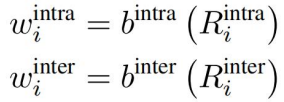

作者设计了针对support的注意力机制,SAM,其实比较简单,这里需要说一下的是inter的分数不是对称的,因此由1到2和由2到1是两个不同的分数。最后经过一个FC映射乘最后的w。

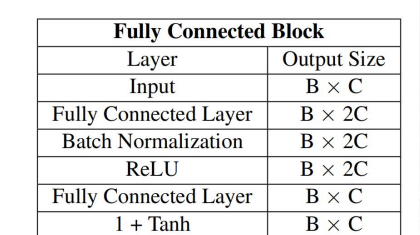

这里的FC结构如下

SAM可以来强调和类别相关的有显著特征的通道,即给这些通道加上更大的权重。

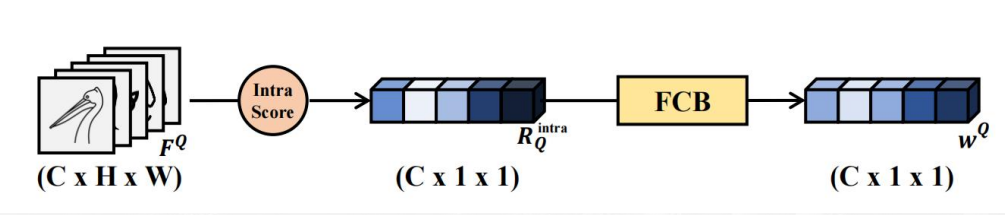

QAM

这里就比较简单了,QAM主要是给和object更相关的通道一个更高的权重,也是很合理。

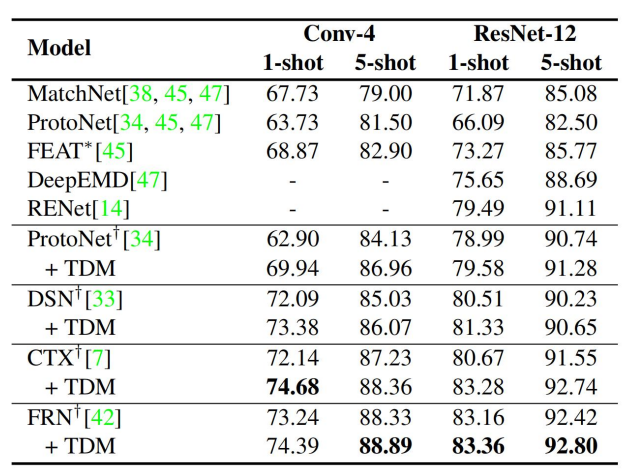

Results

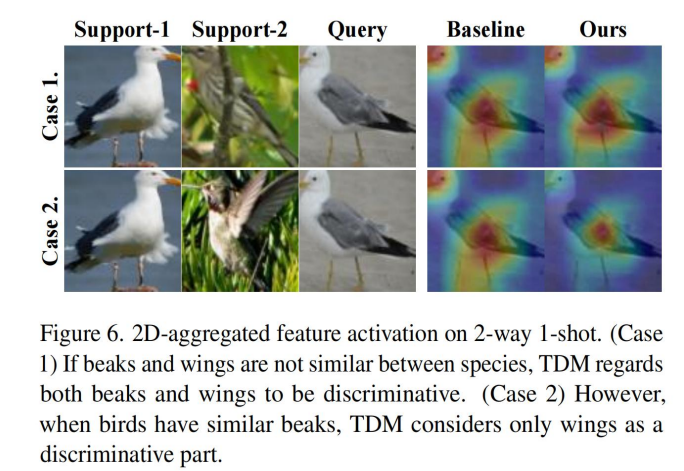

看一下结果,可视化上可以看出这个方法能让模型更关注细节部分

这个方法好的地方就在,可以作为一个插件component结合现在的方法,这我觉得是做工作一个比较好的可以做的点